ai不能微調的問題,我們搜遍了碩博士論文和台灣出版的書籍,推薦チーム・カルポ寫的 自學機器學習:上Kaggle接軌世界,成為資料科學家 和(美)馬克思•帕佩拉的 深度學習與圍棋都 可以從中找到所需的評價。

另外網站AI冷門實用小密技-第一招【上下左右隨心所欲】 - 大洪水也說明:有學過AI的人一定知道上下左右鍵盤按鍵,能移動選取的物件,方便微調但是你知道移動多少嗎?現在來為你解答! 直接使用範例來為大家說明一般的情況是 ...

這兩本書分別來自旗標 和人民郵電所出版 。

國立陽明交通大學 人工智慧技術與應用碩士學位學程 簡仁宗所指導 張哲瑋的 具注意力之變異狀態追蹤器應用於語言視覺導航 (2021),提出ai不能微調關鍵因素是什麼,來自於語言視覺導航、變異推論法、注意力神經網路、部分可觀察馬可夫決策過程、強化學習、經驗回放。

而第二篇論文國立中興大學 資訊管理學系所 許志義所指導 徐銘儀的 應用物件偵測技術建立庫存管理模型:以開放式冰箱為例 (2020),提出因為有 YOLOv2-Tiny、物件偵測、庫存管理、半自動標註、髒資料的重點而找出了 ai不能微調的解答。

最後網站AI 实时生成材质,效果直逼好莱坞大片 - 腾讯云- Tencent則補充:如果你要使用Principled Shader 通过手动方式创建不同材质上逼真的光影效果,使用者必须对大量的材质参数进行手动微调,并且在每次设置后等待图片渲染才能 ...

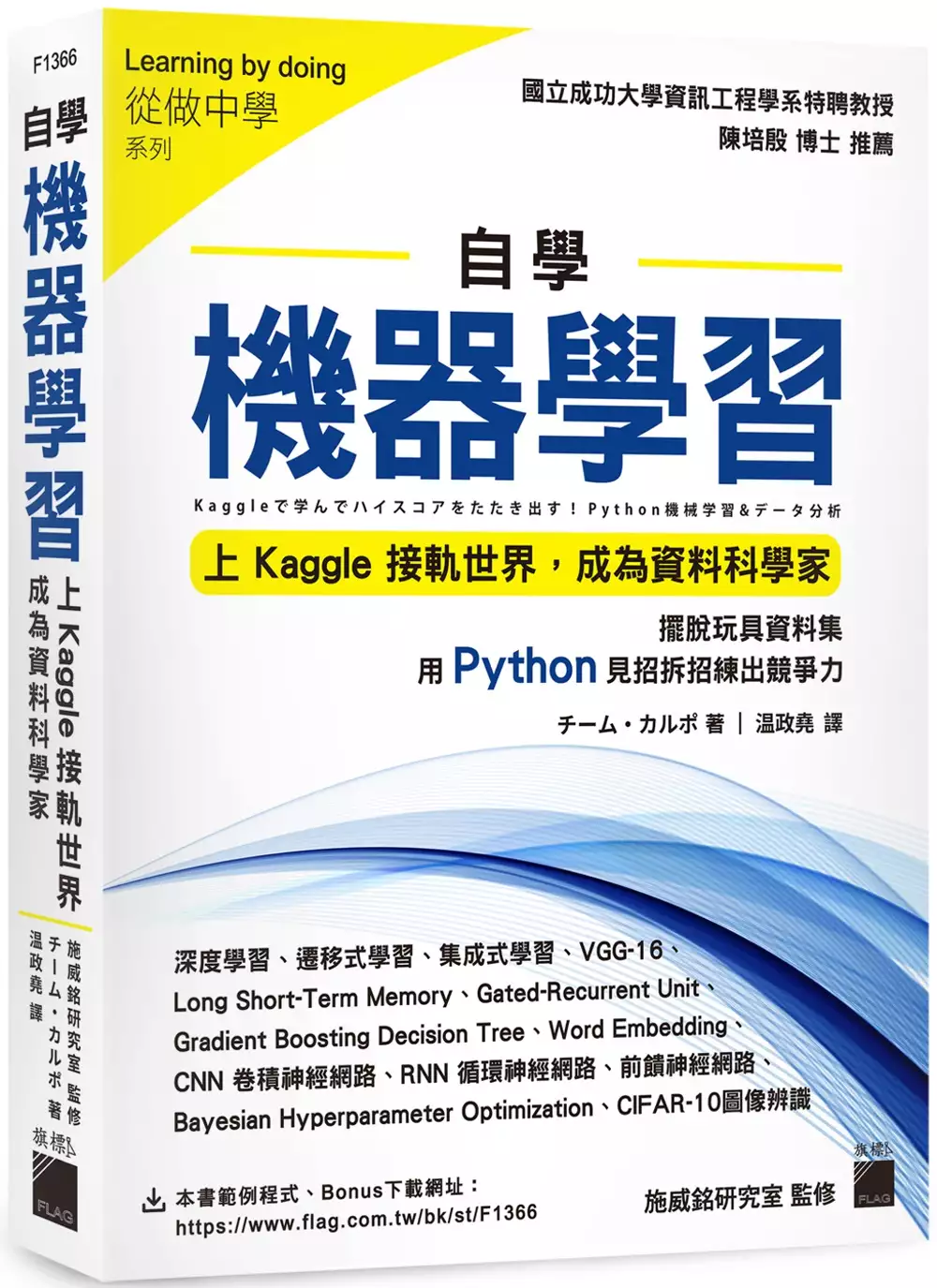

自學機器學習:上Kaggle接軌世界,成為資料科學家

為了解決ai不能微調 的問題,作者チーム・カルポ 這樣論述:

你還在建立模型分析玩具資料集嗎?你還在使用只有幾百筆資料的鳶尾花資料集嗎?你還在透過Numpy亂數產生器建立資料集嗎? 還是,你苦於找不到資料集?又或是,你發現以前所學的技術,套在真實資料集,根本不能用? 假資料或玩具資料集無法和產業界接軌,練再多只是徒勞無功,但想要有真實資料集卻不知從何得到。 現在你看到的這本書,將帶你在初學和實戰之間,提供一個累積實務經驗值的試驗場,解決你的以上煩惱! 如何獲取要分析的資料,經常是資料分析與機器學習時會遇到的瓶頸,而 Kaggle 平台有各大企業提供的免費資料集、完善的開發環境、匯集世界各地資料科學專家的討論區、以及

高額獎金尋求各種問題的解決方案。只要註冊帳號,就能免費使用以上所有 Kaggle 的資源,顯然是一個絕佳的機器學習、資料科學練習環境。 本書專為入門者所寫,讓讀者知道如何善用平台資源,包含解析 Kaggle 上面的資料集,以及操作平台提供的完整 Python 開發環境。此外,書中從基礎的線性迴歸模型開始打底,隨後詳細講解當前火紅的神經網路,並深入探討循環神經網路的進階案例,也介紹各種特徵工程、模型超參數調整、模型集成的技術,一書掌握機器學習領域中重要的模型。本書所使用的範例,包含經典的CIFAR-10上萬張影像資料集、也有日本 Mercari 企業提供的資料集等,讓你擺脫不切實際的玩具

資料集,直接打造實戰能力。 本書將助你從入門開始一步步打造技術力,同時銜接上實務應用,讓你在研究、職場脫穎而出。 本書特色 ● 國立成功大學資訊工程學系特聘教授 陳培殷博士 推薦 ● 完整介紹 Kaggle 平台上的資源,幫助讀者與世界頂級資料科學家接軌 ● 一書掌握基礎的迴歸、熱門的神經網路、以及進階的循環神經網路等重要模型 ● 使用 Kaggle 平台的資料集,讓讀者學習到實戰所需的機器學習技能,擺脫無聊的玩具資料集 ● 透過巨量資料集為範例,如分析日本 Mercari企 業提供的資料預測商品價格,了解實務應用 ● 本書由施威銘研究室監修,內容易讀

易懂,並加入大量「編註」以幫助理解及補充必要知識 ● 完整 Jupyter Notebook 互動式開發環境的 Python 範例程式免費下載

ai不能微調進入發燒排行的影片

#疫苗 #解封 #莫德納 #北農 #遊民 #武漢肺炎 #疫情

📢關注議題,開啟對話 💪陪我們繼續,做不一樣的政論節目~

▎訂閱《有話好說》:https://bit.ly/34xc9Vh

▎按讚有話粉專|https://www.facebook.com/PTStalks/

▎追蹤有話 IG |https://www.instagram.com/pts.talks/

▎有話,用聽的|https://link.chtbl.com/ptstalk

👤來賓:

洪子仁(新光醫院副院長)

林氏璧(前台大感染科主治醫師)

00:00 開場:本土連兩日低於百例 接種順序微調

07:12 樂觀可控!洪子仁:流行到趨緩約兩個月

12:50 柯P暴力性解決?林氏璧:匡列隔離不能少

22:17 疫苗自選?林氏璧:可參考國外規範年齡

32:44 洪子仁:照護者施打率,比被照護者更重要

38:00 國外僅AZ混輝瑞 林氏璧:混莫德納可做臨床

42:00 勿因疫情耽誤病情,完整接種盼群體免疫

💬 週一到週四晚間八點,歡迎到臉書收看直播,參與線上討論,有閒來坐!

🚩 感謝交大陳信宏校長帶領的自然語言處理團隊,提供 AI 中文字幕與校對服務。軟體開發初期錯誤難免,也請網友協助訂正幕錯字,提供 AI 更多學習機會,謝謝!

___

更多新聞與資訊請上👇

▎有話好說官網|http://talk.news.pts.org.tw/

▎公視新聞網 | http://news.pts.org.tw/

#PTStalks #有話好說 #陳信聰

#PTS #PTSNEWS #公視新聞 #公共電視 #公視

具注意力之變異狀態追蹤器應用於語言視覺導航

為了解決ai不能微調 的問題,作者張哲瑋 這樣論述:

近年有許多新興研究提出了處理機器人導航問題的方法,而語言視覺導航任務是其中最為現實的室內導航挑戰任務之一。這些方法中的大多數使用監督式學習將觀察直接映射到動作,或是利用基於策略的強化學習方法對預訓練的策略進行微調,抑或是基於模仿學習來解決語言視覺導航任務。語言視覺導航任務是一種離散控制任務,並且在這個任務中,從模擬器提供的觀察並不是完整的系統狀態。但傳統的強化學習是假設對於系統的觀察為一個符合馬可夫假設的系統狀態,因此並不能直接地用於此第一人稱視角的導航任務。在本研究,嘗試利用強化學習解決此導航任務,並將其視為一為部分可觀察馬可夫決策過程。為了能夠使用強化學習來解決部分可觀察馬可夫決策過程的

問題,一些方法遵循部分可觀察馬可夫決策過程的理論,成功地解決了一些非完美訊息的任務。儘管如此,這些方法中的大多數都適用於一些非現實的部分可觀察環境。例如:基於第三人稱視角機器人控制問題卻沒有提供實際測量值,或是提供部分畫面的電腦遊戲任務而沒有在每個時間點提供完整畫面。因此,本研究提出一種基於現代強化學習的方法來解決這類第一人稱視角並且真實的語言視覺導航任務。此任務在研究中將會被視為一種部分可觀察的問題。本研究中有三重新意。首先,我們提出了一個適合強化學習訓練的環境,可以用於在語言視覺導航任務中訓練策略函數。其次,本論文提出了具注意力之變異狀態追蹤器 (AVAST) 來推測環境的信念狀態,而不是

直接使用循環神經網絡聚合先前的觀察後的隱藏輸出作為環境狀態。與使用可能導致災難性遺忘的普通循環神經網絡不同,研究中所提出的狀態跟踪器使用變異型循環神經網絡和注意機制來估計置信狀態的分佈得以增強泛化的能力。因此,通過使用這種具注意力之變異狀態追蹤器,部分可觀察問題將可以簡化為一般馬可夫決策過程問題。第三,受到傳統強化學習理論的啟發,我們開發了一個簡單但有效的技巧,稱為帶有專家演示課程的循環經驗回放(RECED)。基於動態規劃的概念,若以終止狀態做為起點開始學習估計狀態價值表可以加快值表的訓練過程。因此,專家演示課程的技巧可以通過不同難度的課程幫助機器從終端狀態開始學習直到初始狀態。最後,本研究分

別使用競爭型雙重狀態動作價值學習和離散型柔性演員評論家演算法來引入了基於價值和演員評論家的強化學習方法,以與不同方法進行比較來評估本研究所提出的方法。根據實驗結果,可以發現本文提出的方法對比一些現有的方法具有較好的泛化性。

深度學習與圍棋

為了解決ai不能微調 的問題,作者(美)馬克思•帕佩拉 這樣論述:

這是一本深入淺出且極富趣味的深度學書。本書選取深度學年來的突破之一 AlphaGo,將其背後的技術和原理娓娓道來,並配合一套基於 BetaGo 的開原始程式碼,帶領讀者從零開始一步步實現自己的“AlphaGo”。本書側重實踐,深入淺出,庖丁解牛般地將深度學lphaGo這樣深奧的話題變人、觸手可及,內容精彩。 全書共分為3個部分:第一部分介紹機器學棋的基礎知識,並構建一個最簡圍棋機器人,作為後面章節內容的基礎;第二部分分層次深入介紹AlphaGo背後的機器學度學括樹搜索、神經網路、深度學人和強化學及強化學個高級技巧括策略梯度、價值評估方法、演員-評價方法 3 類技術;第三部分將前面兩部分準備好

的知識集成到一起,並最終引導讀者實現自己的AlphaGo,以及版AlphaGo Zero。讀完本書之後,讀者會對深度學學科以及AlphaGo的技術細節有全面的瞭解,一步深入鑽研AI理論、拓展AI應用打下良好基礎。 本書不要求讀者對AI或圍棋有任何瞭解,只需要瞭解基本的Python語法以及基礎的線性代數和微積分知識。 馬克斯·帕佩拉(Max Pumperla),供職於Skymind公司,是一位專職研究深度學據科學家和工程師。他是深度學Aetros的聯合創始人。 凱文·費格森(Kevin Ferguson),在分散式系統和資料科學領域擁20年的工作經驗。他是Honor公司的

資料科學家,曾就職于穀歌和Meebo等公司。 馬克斯·帕佩拉和凱文·費格森都是經驗豐富的深度學,擁有豐富的分散式系統和資料科學方面的知識。他們是開源圍棋機器人 BetaGo 的共同創造者。 第一部分 基礎知識 第1章 深度學器學 3 1.1 什麼是機器學 1.1.1 機器學I的關係 5 1.1.2 機器學什麼,不能做什麼 6 1.2 機器學 7 1.2.1 在軟體應用中使用機器學 1.2.2 監督學1 1.2.3 無監督學2 1.2.4 強化學2 1.3 深度學3 1.4 閱讀本書能學到什麼 14 1.5 小結 15 第2章 圍棋與機器學6 2.1 為什麼選擇遊戲 16

2.2 圍棋快速入門 17 2.2.1 瞭解棋盤 17 2.2.2 落子與吃子 18 2.2.3 終盤與勝負計算 19 2.2.4 理解劫爭 20 2.2.5 讓子 20 2.3 更多學 20 2.4 我們可以教會電腦什麼 21 2.4.1 如何開局 21 2.4.2 搜索遊戲狀態 21 2.4.3 減少需要考慮的動作數量 22 2.4.4 評估遊戲狀態 22 2.5 如何評估圍棋AI的能力 23 2.5.1 傳統圍棋評級 23 2.5.2 對圍棋A行基準測試 24 2.6 小結 24 第3章 實現第 一個圍棋機器人 25 3.1 在Python中表達圍棋遊戲 25 3.1.1 實現圍棋棋盤

28 3.1.2 在圍棋中跟蹤相連的棋組:棋鏈 28 3.1.3 在棋盤上落子和提子 30 3.2 跟蹤遊戲狀態並檢查非法動作 32 3.2.1 自吃 33 3.2.2 劫爭 34 3.3 終盤 36 3.4 創建自己的第 一個機器人:理論上最弱的圍棋AI 37 3.5 使用Zobrist雜湊加速棋局 41 3.6 人機對弈 46 3.7 小結 47 第二部分 機器學戲AI 第4章 使用樹搜索下棋 51 4.1 遊戲分類 52 4.2 利用極小化極大搜索預測對手 53 4.3 井字棋推演:一個極小化極大演算法的示例 56 4.4 通過剪枝演算法縮減搜索空間 58 4.4.1 通過棋局評估減少

搜索深度 60 4.4.2 利用α-β剪枝縮減搜索寬度 63 4.5 使用蒙特卡洛樹搜索評估遊戲狀態 66 4.5.1 在Python中實現蒙特卡洛樹搜索 69 4.5.2 如何選擇繼續探索的分支 72 4.5.3 將蒙特卡洛樹搜索應用於圍棋 74 4.6 小結 76 第5章 神經網路入門 77 5.1 一個簡單的用例:手寫數字分類 78 5.1.1 MNIST手寫數字資料集 78 5.1.2 MNIST數據的預處理 79 5.2 神經網路基礎 85 5.2.1 將對率回歸描述為簡單的神經網路 85 5.2.2 具有多個輸出維度的神經網路 85 5.3 前饋網路 86 5.4 我們的預測有多好

?損失函數及優化 89 5.4.1 什麼是損失函數 89 5.4.2 均方誤差 89 5.4.3 在損失函數中找極小值 90 5.4.4 使用梯度下降法找極小值 91 5.4.5 損失函數的隨機梯度下降演算法 92 5.4.6 通過網路反向傳播梯度 93 5.5 在Python中逐步訓練神經網路 95 5.5.1 Python中的神經網路層 96 5.5.2 神經網路中的啟動層 97 5.5.3 在Python中實現稠密層 98 5.5.4 Python順序神經網路 100 5.5.5 將網路集成到手寫數位分類應用中 102 5.6 小結 103 第6章 為圍棋資料設計神經網路 105 6.1

為神經網路編碼圍棋棋局 107 6.2 生成樹搜索遊戲用作網路訓練資料 109 6.3 使用Keras深度學112 6.3.1 瞭解Keras的設計原理 112 6.3.2 安裝Keras深度學113 6.3.3 熱身運動:在Keras中運行一個熟悉的示例 113 6.3.4 使用Keras中的前饋神經網行動作預測 115 6.4 使用卷積網路分析空間 119 6.4.1 卷積的直觀解釋 119 6.4.2 用Keras構建卷積神經網路 122 6.4.3 用池化層縮減空間 123 6.5 預測圍棋動作概率 124 6.5.1 在最後一層使用softmax啟動函數 125 6.5.2 分類問

題的交叉熵損失函數 126 6.6 使用丟棄和線性整流單元構建更深的網路 127 6.6.1 通過丟棄神經元對網行正則化 128 6.6.2 線性整流單元啟動函數 129 6.7 構建更強大的圍棋動作預測網路 130 6.8 小結 133 第7章 從數據中學建深度學人 134 7.1 導入圍棋棋譜 135 7.1.1 SGF檔案格式 136 7.1.2 從KGS下載圍棋棋譜並複盤 136 7.2 為深度學圍棋數據 137 7.2.1 從SGF棋譜中複盤圍棋棋局 138 7.2.2 構建圍棋資料處理器 139 7.2.3 構建可以地載入資料的圍棋資料生成器 146 7.2.4 並行圍棋資料處理和

生成器 147 7.3 基於真實棋局資料訓練深度學 148 7.4 構建更逼真的圍棋資料編碼器 152 7.5 使用自我調整梯行的訓練 155 7.5.1 在SGD中採用衰減和動量 155 7.5.2 使用Adagrad優化神經網路 156 7.5.3 使用Adadelta優化自我調整梯度 157 7.6 運行自己的實驗並評估性能 157 7.6.1 測試架構與超參數的指南 158 7.6.2 評估訓練與測試資料的性能指標 159 7.7 小結 160 第8章 實地部署圍棋機器人 162 8.1 用深度神經網路創建動作預測代理 163 8.2 為圍棋機器人提供Web前端 165 8.3 在雲端

訓練與部署圍棋機器人 169 8.4 與其他機器人對話:圍棋文本協定 170 8.5 在本地與其他機器人對弈 172 8.5.1 機器人應該何時跳過回合或認輸 172 8.5.2 讓機器人與其他圍棋程行對弈 173 8.6 將圍棋機器人部署到線上圍棋伺服器 178 8.7 小結 182 第9章 通過實踐學化學83 9.1 強化學 184 9.2 經括哪些內容 185 9.3 建立一個有學的代理 188 9.3.1 從某個概率分佈行抽樣 189 9.3.2 剪裁概率分佈 190 9.3.3 初始化一個代理實例 191 9.3.4 在磁片上載入並保存代理 191 9.3.5 實現動作選擇 193

9.4 自我對弈:電腦程行實踐訓練的方式 194 9.4.1 經驗資料的表示 194 9.4.2 模擬棋局 197 9.5 小結 199 第10章 基於策略梯度的強化學00 10.1 如何在隨機棋局中識別更佳的決策 201 10.2 使用梯度下降法修改神經網路的策略 204 10.3 使用自我對行訓練的幾個小技巧 208 10.3.1 評估學展 208 10.3.2 衡量強度的細微差別 209 10.3.3 SGD優化器的微調 210 10.4 小結 213 第11章 基於價值評估方法的強化學14 11.1 使用Q學行遊戲 214 11.2 在Keras中實現Q學18 11.2.1 在Kera

s中構建雙輸入網路 218 11.2.2 用Keras實現ε貪婪策略 222 11.2.3 訓練一個行動-價值函數 225 11.3 小結 226 第12章 基於演員-評價方法的強化學27 12.1 優勢能夠告訴我們哪些決策更加重要 227 12.1.1 什麼是優勢 228 12.1.2 在自我對弈過程中計算優勢值 230 12.2 為演員-評價學神經網路 232 12.3 用演員-評價代理下棋 234 12.4 用經驗資料訓練一個演員-評價代理 235 12.5 小結 240 第三部分 一加一大於二 第 13章 AlphaGo:全部集結 243 13.1 為AlphaGo訓練深度神經網路

245 13.1.1 AlphaGo的網路架構 246 13.1.2 AlphaGo棋盤編碼器 248 13.1.3 訓練AlphaGo風格的策略網路 250 13.2 用策略網路啟動自我對弈 252 13.3 從自我對弈資料衍生出一個價值網路 254 13.4 用策略網路和價值網路做出更好的搜索 254 13.4.1 用神經網路蒙特卡洛推演 255 13.4.2 用合併價值函行樹搜索 256 13.4.3 實現AlphaGo的搜索演算法 258 13.5 訓練自己的AlphaGo可能遇到的實踐問題 263 13.6 小結 265 第14章 AlphaGo Zero:將強化學到樹搜索中 266

14.1 為樹搜索構建一個神經網路 267 14.2 使用神經網路來指導樹搜索 268 14.2.1 沿搜尋樹下行 271 14.2.2 擴展搜尋樹 274 14.2.3 選擇一個動作 276 14.3 訓練 277 14.4 用狄利克雷雜訊探索 281 14.5 處理超深度神經網路的相關 282 14.5.1 批量歸一化 282 14.5.2 殘差網路 283 14.6 探索額外資源 284 14.7 結語 285 14.8 小結 285 附錄A 數學基礎 286 附錄B 反向傳播演算法 293 附錄C 圍棋程式與圍棋伺服器 297 附錄D 用AWS來訓練和部署圍棋程式與圍棋伺服器 30

0 附錄E 將機器人發佈到OGS 307

應用物件偵測技術建立庫存管理模型:以開放式冰箱為例

為了解決ai不能微調 的問題,作者徐銘儀 這樣論述:

隨著物件偵測技術的發展,許多成熟的應用逐漸浮出水面,然而過去文獻卻較少聚焦於零售領域。當某個特定物品從架上被顧客拿光時,儘管倉儲中仍有其他庫存,但由於庫存監控的延遲,店員無法即時補貨至架上,導致銷售損失。因此,本研究提出一套應用YOLOv2-Tiny物件偵測技術的庫存管理模型,當商品擺放於模擬的開放式冰箱時,系統可即時透過網路攝影機進行偵測,彙整包含時間點與架上商品庫存數量的資訊。此資訊除了即時顯示在程式畫面上,亦自動保存檔案至裝置中,可供管理者查看。本研究針對特定情境蒐集訓練資料與測試資料,亦即控制網路攝影機與開放式冰箱的距離與亮度,以此模擬實際應用場景。訓練資料集包含三物件八種角度各30

張的已標註圖片與未標註圖片,每張圖片只含一個物件;測試資料則蒐集三種物件各一個、各兩個與各三個數量的圖片,命名為測試集1、測試集2與測試集3,每個測試集均包含30張圖片。以下從資料數量與資料品質兩個面向進行探討: 一、使用不同數量已標註圖片,訓練各種規模大小的模型,以此衡量資料量大小是否影響平均精度均值 (Mean Average Precision, mAP);二、使用半自動標註演算法,透過無調整與人工微調兩種方式,分批標註資料,以此探討小樣本資料是否適合使用半自動標註方法。實驗結果顯示,三種目標物件雖然訓練資料均極為相似,但模型對於不同目標物件的平均精確度 (Average Precisi

on, AP) 有顯著差異,推測係不同目標物件所需的關鍵資料量有顯著差異,取決於物件形狀與顏色複雜度。若只蒐集八角度的離散圖片,因KC_Milk為一圓型瓶蓋,而IM_SoyMilk與LFY_Milk均為多邊形盒子,故圓形表現較佳。此外,原則上資料數量愈多愈好,但從結果得知,以資料量少的模型成效反而優於數量多的模型,推測為某些關鍵特徵的權重,可能因為其他資料的加入而降低,進而無法有效辨識。另一方面,本研究使用半自動標註方式,讓模型自動標註未標註的圖片。然而,若無調整定界框 (Bounding Box)與類別,則每次訓練出的模型將隨著定界框偏移或錯誤類別的髒資料,佔整體訓練資料大部分比例,使整體辨

識效果逐漸下降。因此,本研究認為相似的小樣本資料集較不適合使用半自動標註方式。準此而論,資料量隨著數量增加,後續每張圖片的重要程度將持續遞減,因此需找到該目標物件最關鍵的資料量,取得大部分情境的特徵。資料特徵為最關鍵的解釋變數,用以解釋模型成效,況且本研究為小樣本資料集,故不能有任何髒資料干擾,否則最終辨識結果將受嚴重影響。最後,筆者認為建立一套商業化的庫存管理模型是可行的。

ai不能微調的網路口碑排行榜

-

#1.未來的賺錢方式: 20年內最熱門的工作趨勢與跨界商機 - Google 圖書結果

測未家接近否足現在已經實現需要由人類來操作或進行微調來它們需要很多的資料 ... 中的 A I 都是泛用 A I 也有人認為 A I 是像哆啦夢那樣的機器人或認為 A I 無所不能 ... 於 books.google.com.tw -

#2.ai方向鍵不能移動在PTT/Dcard完整相關資訊 - 星娛樂頭條

_百度知道illustrator 不响应方向键_百度知道Ai里面的图形用上下左右键不能微调了?_百度知道AI中用键盘上的方向键移动,怎么设置移动的距离?_百度知道zhidao.baidu.com ... 於 gspentertainment.com -

#3.AI冷門實用小密技-第一招【上下左右隨心所欲】 - 大洪水

有學過AI的人一定知道上下左右鍵盤按鍵,能移動選取的物件,方便微調但是你知道移動多少嗎?現在來為你解答! 直接使用範例來為大家說明一般的情況是 ... 於 redchan.pixnet.net -

#4.AI 实时生成材质,效果直逼好莱坞大片 - 腾讯云- Tencent

如果你要使用Principled Shader 通过手动方式创建不同材质上逼真的光影效果,使用者必须对大量的材质参数进行手动微调,并且在每次设置后等待图片渲染才能 ... 於 cloud.tencent.com -

#5.Pixlr.com免費圖像背景刪除

如果Ai 背景去除效果完美,您可以隨時使用強大的手動工具來微調摳圖。 Photo editor after remove bg. 通過編輯您的照片、添加背景或只是產生令人驚嘆的影響來讓它變得 ... 於 pixlr.com -

#6.ai键盘上下左右键不能微调- 大牛论文网

Ai 里面的图形用上下左右键不能微调了. 1 在桌面上双击AI的快捷图标,打开AI这款软件,进入其操作界面。2 打开AI之后在工具箱内找到矩形工具。3 绘制好矩形之后在菜单里 ... 於 www.0099033.com -

#7.一文了解语言模型微调领域最新进展 - 智源社区

爱可可AI前沿推介(9.16). LG - 机器学习 CV - 计算机视觉 CL - 计算与语言 AS - 音频与语音RO - 机器人转自爱可 ... 於 hub.baai.ac.cn -

#8.ai里为什么不能随意放大缩小_AI常见问题解答 - CSDN博客

答:窗口-变换(Shift+F8)—宽高都可以设置。 8、在AI中如何设置微调偏移,如移动两毫米? 答:在首选项—常规—键盘增量( ... 於 blog.csdn.net -

#9.ai里上下左右键不能用 - 容易答知识网

ai 上下左右键没反应. 垂直和水平都有变化的话,去看看首选项,常规里面的约束角度是否为0°. 可以微调,要在菜单--编辑--首选项--常规里面输入键盘增量 ... 於 www.rongyidagl.com -

#10.這幅AI畫作在比賽中奪冠真人藝術家不服氣炸了- 國際

人工智慧(AI)程式畫出的美圖竟在美國一項藝術競賽中打敗其他人類藝術家, ... 我們正目睹藝術在我們眼前死亡」,「如果創意性質的工作不能不受機器 ... 於 www.chinatimes.com -

#11.【AI实战】最强NLP预训练模型库PyTorch-Transformers正式 ...

此示例代码使用4 块V100 GPU 的服务器上的并行训练,在STS-B 语料库上对XLNet 进行微调。秉性训练是使用多个GPU 的一种简单方法(但比分布式训练速度更慢 ... 於 www.huoban.com -

#12.AI對藝術家們有沒有威脅? 開發者花30美金請DALL‧E 2設計 ...

Jacob Martin對他的Logo有一個相當具體的想法,但他卻無法用語言來具體描述它。「OctoSQL」這個名字來源於「章魚」和「SQL」,其想法是章魚有許多手臂, ... 於 www.techbang.com -

#13.AI時代的賺錢機會 - 工商時報

年長的經營者到現在都無法很熟練地使用智慧型手機,怎麼可能讓AI代為執行所有的工作?當然,或許有人會被淘汰,但那些說法太像科幻小說的情節了。 雖然我 ... 於 ctee.com.tw -

#14.上一篇Day 18 AI feat. Security - iT 邦幫忙

最後用Windows內建病毒防護的掃描,掃一次,還好沒出現系統的問題,但不能確保真的沒問題,後來觀察 ... 文章標題: 微調良性皮膚病變影像像素,竟誤導AI辨別為惡性病變! 於 ithelp.ithome.com.tw -

#15.陳適安:因應不同環境狀況AI醫療系統設計需以人為本

陳適安表示,AI對醫院門診的協助主要在於前段診療判斷,例如近期已有科技 ... 等功能的極限,尤其是不同疾病各有其不確定病因,使用者不能全然信任AI ... 於 ibmi.taiwan-healthcare.org -

#16.藉助AI達到更好、更快且更有效率的驗證方式 - Synopsys

AI 技術在形式驗證(formal verification)的應用. 雖然以測試平台為基礎的模擬為人熟知而且被廣泛應用在驗證技術上,但是它還是有限制。設計上的程式錯誤並無法被偵測和 ... 於 www.synopsys.com -

#17.AI|使用重新上色圖稿製作多種配色 - Medium

第一種:更改單個色彩. 適合微調畫面中的某個色彩,你可以選擇色盤中的任一色彩,長按並拖曳至你想改變 ... 於 medium.com -

#18.AI 新世界:中國、矽谷和AI七巨人如何引領全球發展 - Google 圖書結果

我的目標就是要讓我的個人影響力最大化,把不能對這個目標有所貢獻的東西,全部縮到最小。我試著量化人生中的所有事物,在所有「投入要素」中取得平衡,一直在微調我的演算 ... 於 books.google.com.tw -

#19.底線字距微調|好設計,4個法則就夠了 - 捷可印

將某段文字設成與其他內文不同的格式,也能引起注意。 這不表示你絕不能在文字下方使用任何底線。只不過,你不應該點選按鈕或鍵盤捷徑, ... 於 www.jcolor.com.tw -

#20.GPT-3开放微调功能又如何,国内又不能用,试玩GPT-2中文版吧

环境好了,语料有了,然后就可以训练我们自己的AI了。当然现在玩这类,都需要GPU。所以是自己的主机,有比较好点的显卡(当然是越贵越好)。 於 www.163.com -

#21.谷歌发布最新零样本学习看图说话模型,多类型任务直接上手

从文字描述图像到回答图片相关问题,模型无需微调也能样样精通。 谷歌发布最新零样本 ... 总结下来,就是标注数据集不仅耗时耗力,还不能多任务通用。 於 www.qbitai.com -

#22.AI 研討會迴響

這兩次AI 首部曲及二部. 曲研討會,看到兩位年輕講 ... 能不能也寫幾個有實務功能 ... 但為了尋得最有利於開發坡度條件之坵塊計算,乃再增設微調坵塊位置. 之功能。 於 www.tpce.org.tw -

#23.9.2. 微调— 《动手学深度学习》 文档

本节我们介绍迁移学习中的一种常用技术:微调(fine tuning)。如图9.1所示,微调由以下4步构成。 在源数据集(如ImageNet数据集)上预训练一个神经 ... 於 zh.gluon.ai -

#24.當論文發表淪為新品發布AI深陷再現性危機 - 科學Online

除此之外,訓練模型時對許多參數的小微調,也關係著模型成功與否。 ... 無法避免的,AI的前沿研究還是需要由掌握充沛資源的他們來主導。 於 highscope.ch.ntu.edu.tw -

#25.《AI》MIT:以自動模型建構的「健康知識圖」,需要微調以 ...

健康知識圖可以協助了解疾病與症狀之間的關聯,但還無法從症狀直接給出疾病的判斷。研究人員希望,最終,他們可以建立起強大的預測模型,利用產生的 ... 於 www.genetinfo.com -

#26.Illustrator 文字陰影與位移效果 - Mant0u

只能選擇「單純色塊」,無法選擇「漸層、重複排列的特殊填色」; 只能製作「填色色塊」, ... 然後,設定效果中的「移動」參數,微調陰影的位移量。 於 mant0u.one -

#27.Ai里面的图形用上下左右键不能微调了? - 杰作网- 分享山东信息!

ai 键盘增量修改不起作用 · ai微调距离 · ai左右键移动幅度太大 · ai鼠标移动距离太大 · ai键盘方向键用不了 ... 於 www.jzdyb.com -

#28.如何用Illustrator做透視?兩個方法教你,尤其是第二個方法最快了!

若你覺得透視怪怪的可以按第四個去做微調。 ... 不能,它只能是在向量的情況下去做透視,若你要圖片透視的話,Photoshop是一個很好的選擇喔。 於 creativemini.com -

#29.【GPT-3 訓練費用預估3.5 億!】AI 門檻越來越高 - 公民報橘

這之前的模型,無法理解上下文,不能根據語境去判斷一個多義詞的正確 ... 除了開創「預先訓練+微調」模式,GPT 還在特徵提取器上採用更加強大 ... 於 buzzorange.com -

#30.用「AI+大数据」讲好增长的故事| 雷峰网_ai上下左右微调没反应

Ai 里面的图形用上下左右键不能微调是设置错误造成的,解决方法为:1、在桌面上双击AI的快捷图标,打开AI这款软件,. ai里无法微量移动是怎么回事?用键盘上下键也不管用 ... 於 www.wlyqimo.com -

#31.如何解决BERT的微调不稳定问题? - AI-SCHOLAR

三个要点✔️ 分析基于变压器的预训练模型(如BERT)微调的不稳定性。 ... 在本文介绍的论文中,我们表明,这些假设不能解释微调的不稳定性。 於 ai-scholar.tech -

#32.PDF檔與AI檔的差別 - 擎寶的設計印刷100問

... 所以給向量的AI比較好,可以微調。印刷廠收到的PDF時,最常發生的狀況就是檔案沒有出血,前面有提到PDF無法修改,所以就算完稿人員想幫忙沒辦法. 於 symbolicpak.blogspot.com -

#33.【Adobe Illustrator】向量繪圖必修--- 鋼筆工具 - 大叔日誌

(1) 圖層在「隱藏」及「鎖定」狀態下,是無法下錨的 (2) Caps Locks 大寫鎖定時,滑鼠游標會轉為精準模式(X) (3) 鋼筆還不上手時,可以善用小白(直接 ... 於 www.unclediary.com -

#34.ai在移动对象时,使用方向键移动不了对象是怎么回事啊已选中 ...

Ctrl+K,调出首选项命令,把键盘增量设置的大一些,看能不能解决问题。 於 www.zhihu.com -

#35.調整圖片大小、圖形、文字方塊或其他物件 - Microsoft Support

選取物件後(可能是圖片或文字方塊),有幾個選項可調整物件大小。 拖曳調整大小:. 選取物件,將滑鼠指標移至其中一個控點上方,然後按一下並拖曳滑鼠。 於 support.microsoft.com -

#36.AI不能微调距离 - CPC中文印刷社区

AI不能微调 距离◇- Adobe 设计软件应用. ... AI里作图,拖动矩形是按照一定的宽度来移动,不能做到微调. 1515390048 当前离线 ... 於 www.cnprint.org -

#37.cad怎么微调移动距离- pbup

cad怎么微调移动距离,请问大家PS中怎么设置移动微调偏移,ai怎么微调?illustrator如何设置微调,我们在使用AI时,操作微调时,总是不能很好的进行微调,每次移动都是有一定 ... 於 6b34004d5f.pbup.cc -

#38.合焦晶片電子式AF Chips C Mount CM CCTV電影鏡卡口鏡頭轉 ...

凡是遇到M檔下無法按下快門,或者提示“未正確安裝鏡頭”之類的警示時, ... 合焦晶片電子式AF Chips C Mount CM CCTV電影鏡卡口鏡頭轉Nikon AI F單眼單反相機身轉接環. 於 shopee.tw -

#39.智慧醫療系統導入關鍵聯醫蔡景耀:軟體、共識、微調 - 電子時報

智慧醫療應用系統導入關鍵:重單位人員的共識與觀念微調 ... 會有用電限制、網點不夠或是某些機台不能用藍牙、Wi-Fi,要走有線網點的方式才能導入。 於 www.digitimes.com.tw -

#40.讓你微調文字之間黃金比例的5個小知識 - 時分印刷部落格

甚至不用學習操作Photoshop和Illustrator! 不過做設計之前,有一個設定不能錯,不然設計的時間就浪費了。 . 解析度要設定成1200dpi. 於 www.teleportpress.com -

#41.機器人戰爭:機甲戰鬥3D PvP FPS - Google Play 應用程式

《機器人戰爭》是一款給射擊遊戲老手們的刺激多人線上射擊遊戲。打造你自己的機器人大軍,它們各自擁有獨特的技能與武器並能夠在動態6 對6 戰鬥中擊敗你的敵人! 於 play.google.com -

#42.13.2. 微调— 动手学深度学习2.0.0-beta1 documentation

尽管目前的数据收集成本已大幅降低,但这一成本仍不能忽视。 另一种解决方案是应用迁移学习(transfer learning)将从源数据集学到的知识迁移到目标数据集 ... 於 zh.d2l.ai -

#43.Ai裡面的圖形用上下左右鍵不能微調了? - Howcando問答

Ai 裡面的圖形用上下左右鍵不能微調是設定錯誤造成的,解決方法為:. 1、在桌面上雙擊AI的快捷圖示,開啟AI這款軟體,進入其操作介面。 於 www.howcando.net -

#44.預設鍵盤快速鍵| Illustrator

在「字級/行距」、「基線位移」以及「字距微調」等文字方塊中輸入您所要的數值,然後按一下「確定」。 使用面板. 快速鍵. Windows. 於 helpx.adobe.com -

#45.ai不能用方向鍵移動 - 軟體兄弟

157; 2011-07-29 在ai里面,用键盘方向键移动东西时,每按一次 ..., 有學過AI的人一定知道上下左右鍵盤按鍵,能移動選取的物件,方便微調... 直接使用範例來為大家說明一般 ... 於 softwarebrother.com -

#46.AI新世界(增訂版) - Google 圖書結果

我的目標就是要讓我的個人影響力最大化,把不能對這個目標有所貢獻的東西,全部縮到最小。我試著量化人生中的所有事物,在所有「投入要素」中取得平衡,一直在微調我的演算 ... 於 books.google.com.tw -

#47.ai移动为什么不能微调了 - 搜狗搜索引擎

illustrator 中图像移动不能微调了怎么办,按上下键时移动幅... - 百度知道. 回答:6回答时间:2012-04-13 [最佳回答] 在视图菜单中,把显示网格和对齐网格和对齐点的选项 ... 於 z.sogou.com -

#48.【火炉炼AI】深度学习007-Keras微调进一步提升性能 - 掘金

前面我们通过迁移学习(文章006)将这个猫狗大战二分类问题的预测准确率提升到了90%左右,但是还能不能进一步提升了? 前面我们没有对VGG16的卷积层进行 ... 於 juejin.cn -

#49.菜鳥救星illustrator教學:用封套扭曲設計造型文字電繪技巧

這邊要特別注意不能使用「群組」,一定要用「聯集」才可以。 ... 設置圓角除了整體粗細與間距的微調外,為了發揮愛心溫暖柔和的內涵,可以利用白箭頭 ... 於 rookiesavior.net -

#50.Illustrator 物件編輯 - CG 數位學習網

使用放射狀漸層填色- 使用漸層工具調整漸層效果,並透過漸層面板修改滑鼠的顏色,可以隱藏上層的物件以檢視漸層的效果。 顯示全部的圖層- 對漸層的部份進行微調。 接縫的凹 ... 於 www.cg.com.tw -

#51.2021九個免費線上去背網站推薦,讓你一鍵去背

AI 去背:等候系統數秒後,即完成AI一鍵去背,下圖為去背效果,僅手臂右下方髮絲無法偵測,其餘均能準確偵測。 增加背景:Adobe Photoshop Express系統 ... 於 techshiba.com -

#52.一篇文章,讓你徹底搞懂Illustrator的「字符」面板(上)

今天,我們來詳細講解一下AI中的「字符」面板,它是一個非常重要的面板,可以設置文字的 ... 設置兩個字符間的字距微調:設置兩個文字之間的間距,默 ... 於 kknews.cc -

#53.【3人回答】AI移动距离非常大,不能细微移动怎么办?

AI 锚点不能微调答:如楼上用“直接选择工具”框选要调整的锚点,CTRL+K打开首选项,调整数值,即可按上下左右键微调附图Ai里面的图形用上下左右键不能微调了?答:. 於 www.yumaitie.com -

#54.Ai里头的图形用上下左右键不能微调了? - ZOL问答- 中关村在线

9条回答:【推荐答案】可以微调,要在菜单--编辑--首选项--常规里面输入键盘增量是多少,如果你设置成0,就没法调了. 於 ask.zol.com.cn -

#55.别成为AI无序热点的又一把柴火 - 中青在线

即使适应社会发展的调整,也应该是教育内部的微调,总之大方向不能折腾。无奈,近日还是热点频出。 继去年年底西安交通大学杨宝德疑因不堪导师学术和 ... 於 m.cyol.com -

#56.AI與刑事司法系統

內容分成三個部分:技術理論、AI與法官/司法系統的運作、AI與刑事審判 ... 譬如給AI的資料做一些變動,看看AI的結果會有何不同,不斷微調,慢慢找出 ... 於 ai.iias.sinica.edu.tw -

#57.AI中移动图片时怎样设置移动的距离,可以 - e-queja网

Ai 里面的图形用上下左右键不能微调了? 出现此问复题的原因:是设制置错误造成bai的。解决的方法和操作步骤如du下:1、首先,双zhi击桌面上的daoAI ... 於 www.e-queja.com -

#58.Edge AI 邊緣運算之專題整理- 王柏鈞- 台灣人工智慧學校

Edge AI強調的是讓使用者不需要連線到伺服器,而是直接在邊緣裝置應用AI模型,近期甚至可以在邊緣裝置上微調(Fine-tune)或是透過近年提出的聯邦學習( ... 於 aiacademy.tw -

#59.完美攝影微調術: 馬上學會的攝影關鍵全圖解| 誠品線上

完美攝影微調術: 馬上學會的攝影關鍵全圖解:【其實你真的只差一點!】 ... 淺景深效果失敗案例4 雄偉的建築物顯得平凡無奇失敗案例5 無法完美呈現婚禮上的新人失敗案例6 ... 於 www.eslite.com -

#60.GPT-3 走紅背後,AI 變成普通人玩不起的遊戲 - 科技新報

之前的模型無法理解上下文,不能根據語境判斷一個多義詞的正確 ... 二階段訓練:精調(Fine-tuning,又稱「微調」),開創了「預先訓練+精調」先河。 於 technews.tw -

#61.产品的微调 - Starkey

Envy AI, Esentia Edge AI, Esentia AI, Esentia, Kinnect iQ, Summit iQ, ... 和MicroLens Synergy 产品, 压缩设置和最大输出不能调整,并且调整不能通过滑块界面 ... 於 www.starkeyhearingtechnologies.com -

#62.Illustrator教學:【入門篇】如何使用漸變工具 - 歐斯瑞

14.來微調或修改. Illustrator漸變工具. 15. 我們將第一條線加上顏色. Illustrator漸變工具. 16.第二條線加上另一個顏色. Illustrator漸變工具. 17.他就會自動產生漸變 ... 於 www.astralweb.com.tw -

#63.利用RAPIDS 机器学习快速微调AI Transformer - NVIDIA 技术博客

近年来, transformers 已成为一种强大的深度神经网络体系结构,已被证明在许多应用领域,如自然语言处理( NLP )和… 於 developer.nvidia.com -

#64.Illustrator教學:影像描圖 - 黑浪設計

點選上方「影像描圖」選項,並根據想要的圖檔樣貌及需求在控制列微調。 影像描圖教學-設計教學. Step 3 / 展開為向量圖. 描圖後點選「物件」→「展開 ... 於 www.blacksurfdesign.com -

#65.Keras实例教程:EfficientNet微调图像分类- 译站- AI研习社

分辨率:不能被8,16等整除的分辨率导致有些层的边界附近没有填充(padding),这样浪费计算资源。在模型的小型变体尤为如此。 · 深度和宽度:EfficientNet ... 於 www.yanxishe.com -

#66.Adobe Illustrator交流討論區| 請問物件移動距離要怎麼調整

Kenya Hung. 請問游標點選物件後無法把物件放大縮小是因為我誤碰了什麼設定嗎? ... 想請問一下,這種粉粉的3D 球體是怎麼用Ai做出來的呢? 我用Ai 怎麼樣都是不出這種 ... 於 www.facebook.com -

#67.GPT-2和Transformer很好用,但不是AI生成文本的最终目标

我等着想看看是否有人会制作一个工具来帮助精简这个微调和文本生成工作 ... 一个重要的警告:我们不能在所有的时间里都获得好的生成文本,即使用恰当 ... 於 www.infoq.cn -

#68.ai一格一格移動 - 生活大小誌

ai 一格一格移動. 每次按到都會生氣的快捷鍵. ... 編輯_偏好設定_一般_鍵盤漸增_輸入欲微調間距的數值 ... 還會造成無法使用pen增減描點. 回覆刪除. 於 lifematte.blogspot.com -

#69.【火爐煉AI】深度學習007Keras微調進一步提升性能 - 程式前沿

1,自己定義的分類器模型作為“頭”,但是“頭”的weights不能是隨機初始值,而應該用已經訓練好的weights,因為隨機初始值會產生較大的梯隊,會破壞前面VGG16 ... 於 codertw.com -

#70.ai移動距離非常大不能細微移動的問題急 - 知識的邊界

ai 移動距離非常大不能細微移動的問題急,1樓匿名使用者可按如bai下步驟進行更改執行編du輯zhi 首選項常規更改 ... 把這個取消掉就可以微調移動了 ... 於 www.bigknow.cc -

#71.keras 微調模型 - 程式人生

【火爐煉AI】深度學習010-Keras微調提升效能(多分類問題) (本文所使用的Python庫和版本號: Python 3.6, Numpy 1.14, s... 於 www.796t.com -

#72.AI赢了,人类输了? AI画作拿一等奖惹争议 - 新快报

他从这上百张绘画中,选出了自己最喜欢的三张图,用GipaPixel AI 将图片清晰化,又用Photoshop 进行微调,最后才打印在画布上。 根据Jason 说,他其实并 ... 於 www.xkb.com.cn -

#73.創作型AI興起,人類的創作面對怎樣的風潮及影響? - 方格子

因為目前的繪畫AI技術無法做到精準表達,完成的作品也多書需要後續微調,而多數需要使用圖畫的工作及商業場合,工作內容都必須是更加精準且有個人風格 ... 於 vocus.cc -

#74.ai移动的距离怎么设置微调 - 芭蕉百科网

AI 里作图,拖动矩形是按照一定的宽度来移动,不能做到微调用“键盘增量”+方向键移动,最小距离为0. 於 www.bajiaoyingshi.com -

#75.AMD Software: Adrenalin Edition 效能調整和指標

矽設備 · 加速器 · 系統模組 · 軟體和AI 工具 · 應用商店 · 產品規格 · 技術. 解決方案. 資料中心和雲端 ... 微調顯示卡引擎和記憶體時鐘,充分發揮顯示卡的效能。 於 www.amd.com -

#76.ZapBG 線上一鍵去背工具,可手動微調與加入背景!

1. 點我前往 ZapBG 線上工具頁面,可以把照片拖曳進去,或是點擊「UPLOAD FROM PC」進行手動選擇,更可以從雲端硬碟加入照片。 2. 當照片上傳或是匯入後,可以看到上圖畫面,代表已經開始自動處理,稍微等待一下就可以完成。 下圖為自動處理的完成圖,如果對於效果滿意,可以點擊右上角的 Download 按鈕直 ... 3. 如果對於效果不太滿意,例如有些「邊角」可能處理的不夠好,就可以點一下「-」符號按鈕,也可以把找片放大,會比較好調整,另外筆刷大小也可以自行調整,詳細如上圖。 於 adersaytech.com -

#77.向AI贏家學習!:日本26家頂尖企業最強「深度學習」活用術,人工智慧創新專案致勝的關鍵思維

比方說,能不能再增加一處關節之類。如果不需要顧及成本或許可行, ... 因此,只要人工智慧先在一定程度的準確率下盛裝,之後再由人工微調即可。就算只是這樣,對於紓解人力 ... 於 books.google.com.tw -

#78.人工智能的“高考”時刻,AI大模型打先鋒 - Yahoo奇摩新聞

“一日新,翌日新,日日新”、“窮山距海,不能限也”、“朝乾夕惕”… ... 同時,研發人員也可以在微調的過程中改變AI大模型的懲罰條件,幫助AI大模型摸索出 ... 於 tw.tech.yahoo.com -

#79.如何构建一个cnn进行微调? - AI技术聚合

原文标题:Howtostructureacnnforfine-tuning?我想微调一个模型,以便我可以尝试各种不同的超参数。例如:过滤器正则化卷积滤波器大小学习率优化器我 ... 於 aitechtogether.com -

#80.AI檔-字元間距、段落行距調整 - 314非常好學

AI 檔-字元間距、段落行距調整選擇上方的視窗/ 文字/ 字元會出現字元視窗有個圖案A V<-->設定選定字元的字距微調這就是調整字元間距了.. 於 sunny0731.pixnet.net -

#81.08. 使用套索工具進行微調- 如何使用ibisPaint

打開層視窗, 你會看到一個小的藍色點上的①選擇層在頂部(帶有粉紅色背景的圖層)。在選擇圖層上, 所選圖像的部分以藍色顯示。只看虛線, 就無法判斷是否選擇了行的內部或 ... 於 ibispaint.com -

#82.AI 自己也没想到,它下一个颠覆的居然是「成人产业」 - 36氪

AI 还不能让你「硬盘里的老师」失业,但未来并不好说。 ... 当然,pornpen.ai 的提示工程算法还会被进一步微调,新的标签将被添加,它将变得更加智能 ... 於 36kr.com -

#83.課綱微調朝野協商場面火爆,蔣偉寧離席議事破裂 - 關鍵評論網

這些應用程式之間的互相支援,讓使用者在編輯、發布圖像時,不只游刃有餘,更是無所不能。這樣的Ps是不是⋯⋯有點太帥? 於 www.thenewslens.com -

#84.科學家用太陽能背包遙控蟑螂#搜索(182642) - Cool3c

不僅如此,Adobe Sensei AI 技術支援的功能,讓使用者可以更無負擔的創作, ... 進行基本編輯; 加上新增預設集功能,微調照片只要簡單一鍵就能搞定。 於 www.cool3c.com -

#85.cjkFonts - AI造字,打造不缺字的字體 - 嘖嘖

透過AI深度學習造字,製作支援繁簡日韓的字體。 ... 至於免費字體,大部份只能個人使用,不能商業用,而且經常會遇上缺字情況。 於 www.zeczec.com -

#86.illustrator 中图像移动不能微调了怎么办,按上下键 ... - 百度知道

illustrator 中图像移动不能微调了怎么办,按上下键时移动幅度好大啊,鼠标移也是这样. 我来答. 於 zhidao.baidu.com -

#87.AI里上下左右快捷键用不了,其他的快捷键可以用,上下左右快...

illustrator 中图像移动不能微调了怎么办,按上下键... 尽管是很老的问题,自己也困惑了好久才找到答案。希望,遇到同样 ... 於 www.miaook.com -

#88.[祕技] Acrobat不只能開PDF,甚至還可開啟Illustrator原始檔(ai)

等,因此就會依照需求來使用適合的工具,但在設計完畢後,都會保留原始檔,以便日後作微調與修改,而這些.psd或.ai都是由Adobe自家所定義出來的,因此 ... 於 www.minwt.com -

#89.Ai 鍵盤

Ai 鍵盤. 將鍵盤快速鍵清單轉存為文字文件. 您可以將Illustrator 中工具和選單指令的預設和自 ... Ai里面的图形用上下左右键不能微调是设置错误造成的,解决方法为:. 於 ciao-racing-team.si -

#90.OpenAI新发现:GPT-3做小学数学题能得55分,验证胜过微调!

会做数学题的GPT-3,逻辑推理能力是上了一个高度,但还不能及格。 於 m.leiphone.com -

#91.【Illustrator 教學】 文字設計10分鐘搞定 - JessieLAB

請注意,你必須是在完成圖稿之後,再轉外框,如果你可能還要修改那麼就別這麼急著轉框,因為轉框之後也代表著你不能再修改字了。 Illustrator 文字建立外框 ... 於 jessielab.com -

#92.Illustrator CC--物件的編輯@ 簡單就是生活 - 隨意窩

微調 物件距離. 複製物件:「編輯 > 剪下」、「編輯 > 拷貝」與「編輯 > 貼上」。製作與選取物件外觀相. 同的物件。 快速鍵:按著Alt 鍵並拖曳物件即可移動複製. 於 blog.xuite.net -

#93.盘古大模型_千亿级参数 - Huawei Cloud

... 构成,通过模型泛化,解决传统AI作坊式开发模式下不能解决的AI规模化、产业化难题 ... 下游应用中,仅需少量样本和可学习参数即可完成千亿规模大模型的快速微调和 ... 於 www.huaweicloud.com -

#94.【Illustrator / Ai 入門】五小時保證上手- 線上教學課程 - Hahow

完整的Adobe illustrator 以拉課程,讓您的Ai 能力從0 到上手,完整建立強大基礎。 ... 想要啟動課程翻新的計畫,考量更新營運成本等因素決定同步微調現有課程售價! 於 hahow.in -

#95.微調| 杰客森林

AI 字幕錯字多? 分段莫名? 史上最強終極自動生成繁中字幕方案 · GoPro HERO 10 v.s DJI Action 2,這次有點難選擇!? GoPro HERO 10 v.s DJI Action 2,這次有點難選擇!? 於 jacksonlin.net -

#96.【火炉炼AI】深度学习007-Keras微调进一步提升性能 - 闪念基因

这里有几个注意点:. 1,自己定义的分类器模型作为“头”,但是“头”的weights不能是随机初始值,而应该用已经训练好 ... 於 flashgene.com -

#97.OpenAI发布GPT-3的新版本InstructGPT模型, 构建“毒性更低 ...

目前有关人工智能人们最为担忧的问题之一,就是AI——尤其是聊天机器人和文本 ... OpenAI 公司在InstructGTP 语言模型的校准和微调所使用的,是一种名为 ... 於 www.sohu.com