DeepMind的問題,我們搜遍了碩博士論文和台灣出版的書籍,推薦董豪,丁子涵,仉尚航寫的 新一代AI霸主:深度強化學習從基礎開始到專案開發 和GeorgeKyriakides,KonstantinosG.Margaritis的 集成式學習:Python 實踐!整合全部技術,打造最強模型都 可以從中找到所需的評價。

另外網站英國Royal Free國家健康服務基金信託與Google DeepMind間 ...也說明:資料來源:. Information Commissioner's Office [ICO], Royal Free-Google DeepMind Trial Failed to Comply with Data Protection Law (July 3, 2017),https ...

這兩本書分別來自深智數位 和旗標所出版 。

國立清華大學 數學系 劉聚仁、鄭志豪所指導 陳柏穎的 隨機過程之散射變換 (2021),提出DeepMind關鍵因素是什麼,來自於散射變換。

而第二篇論文國立陽明交通大學 人工智慧技術與應用碩士學位學程 簡仁宗所指導 張哲瑋的 具注意力之變異狀態追蹤器應用於語言視覺導航 (2021),提出因為有 語言視覺導航、變異推論法、注意力神經網路、部分可觀察馬可夫決策過程、強化學習、經驗回放的重點而找出了 DeepMind的解答。

最後網站What does Google want with DeepMind? Here are three clues則補充:All eyes turned to London this week, as Google announced its latest acquisition in the form of DeepMind, a company that specialises in ...

新一代AI霸主:深度強化學習從基礎開始到專案開發

為了解決DeepMind 的問題,作者董豪,丁子涵,仉尚航 這樣論述:

本書是為「深度強化學習」的專家所提供的最佳參考書! 從 2013 年開始,深度強化學習已漸漸地以多種方式改變了我們的生活和世界,會下棋的AlphaGo技術展示了超過專業選手的理解能力的"圍棋之美"。 類似的情況也會發生在技術、醫療和金融領域。深度強化學習探索了一個人類最基本的問題:人類是如何透過與環境互動進行學習的?這個機制可能成為逃出“巨量資料陷阱”的關鍵因素,作為一條強人工智慧的必經之路,通向人類智慧尚未企及的地方。 本書由一群對機器學習充滿熱情的極強專家完成,展示深度強化學習的世界,透過實例和經驗介紹,加深對深度強化學習的理解。 本書覆蓋內容範圍之廣,從深度強

化學習的基礎理論知識到包含程式細節的技術實現描述,是初學者和科學研究人員非常好的學習教材。 本書特色 ●深度學習精解 〇強化學習入門指引 ●深度Q網路,DQN、Double DQN、Actor-Critic 〇模仿學習 ●整合學習詳解 〇分層、多智慧體強化學習 ●平行計算 〇Learning to Run實作 ●圖型強化實作 〇模擬環境機器人實作 ●Arena多智慧體強化學習平台實作 〇強化學習技巧及最完整所有演算法說明實作

DeepMind進入發燒排行的影片

ทันไอที : อัปเดตข่าวกระชับ ครบ จบที่เดียว

: 00:06 ผลสำรวจปีนี้มือถือแบรนด์จีนยอดขายพุ่งสวนกระแส คนเน้นมือถือคุ้มค่า (อ่านข่าวเต็ม : https://www.gartner.com/en/newsroom/press-releases/2019-11-26-gartner-says-global-smartphone-demand-was-weak-in-thi )

: 03:10 realme อาจจะแยกตัวจาก OPPO มาผลิตมือถือหลังทำยอดขายได้ดี (อ่านข่าวเต็ม : https://www.gsmarena.com/realme_may_spinoff_from_oppo_to_become_fully_independent-news-40315.php )

: 04:34 เซียนโกะถึงกับยอมลาออกจากอาชีพ พยายามแค่ไหนก็ไม่ชนะ AI (อ่านข่าวเต็ม : https://www.theverge.com/2019/11/27/20985260/ai-go-alphago-lee-se-dol-retired-deepmind-defeat?fbclid=IwAR1mlVjVNkwfIJ6fYvI_wbfOnKseVvLEwwl2mQ6K2NVgOiLEGdPWCSAVRTI )

8 โมงเช้า จ.-ศ. กับ Kengkawiz

#IT #tech #update #news

隨機過程之散射變換

為了解決DeepMind 的問題,作者陳柏穎 這樣論述:

用於預測標籤的時間序列分類在現今被廣泛使用。舉例來說,長短期記憶模型被應用於名叫星海爭霸二的複雜遊戲中。而散射變換以及支援向量機也被運用於音樂摘錄上的分類,其準確度可高達87.5%。然而,只有少數論文探討為何這些特徵提取之技巧,可以在理論上應用於非平穩過程。本篇論文將會分成四個章節。在第一個章節中,我們將介紹一些時間序列過程,分別為弱平穩過程、週期性平穩過程、及EPACS 過程。在第二章節中,我們將介紹散射變換,其為一種截取訊號特徵的工具,且可利用腦電圖分類睡眠階段[1]。為了更深入了解散射變換之定義,我們必須先了解一些關於短時距傅立葉變換及小波變換之先備知識和限制。在第三章節中,我們將介紹

一些散射變換於弱相關隨機過程之統計性質,包含散射矩(scattering moment)於卜瓦松過程上以及散射變換於白噪音上。最後,我們將先行介紹NAST ── 散射變換之推廣。接者,我們將會介紹一些NAST 相似於散射變換之性質。最後,我們將說明NAST 於週期平穩過程上的非擴散性質,並著重於解釋為何其為一個良好的提取訊號特徵之工具。

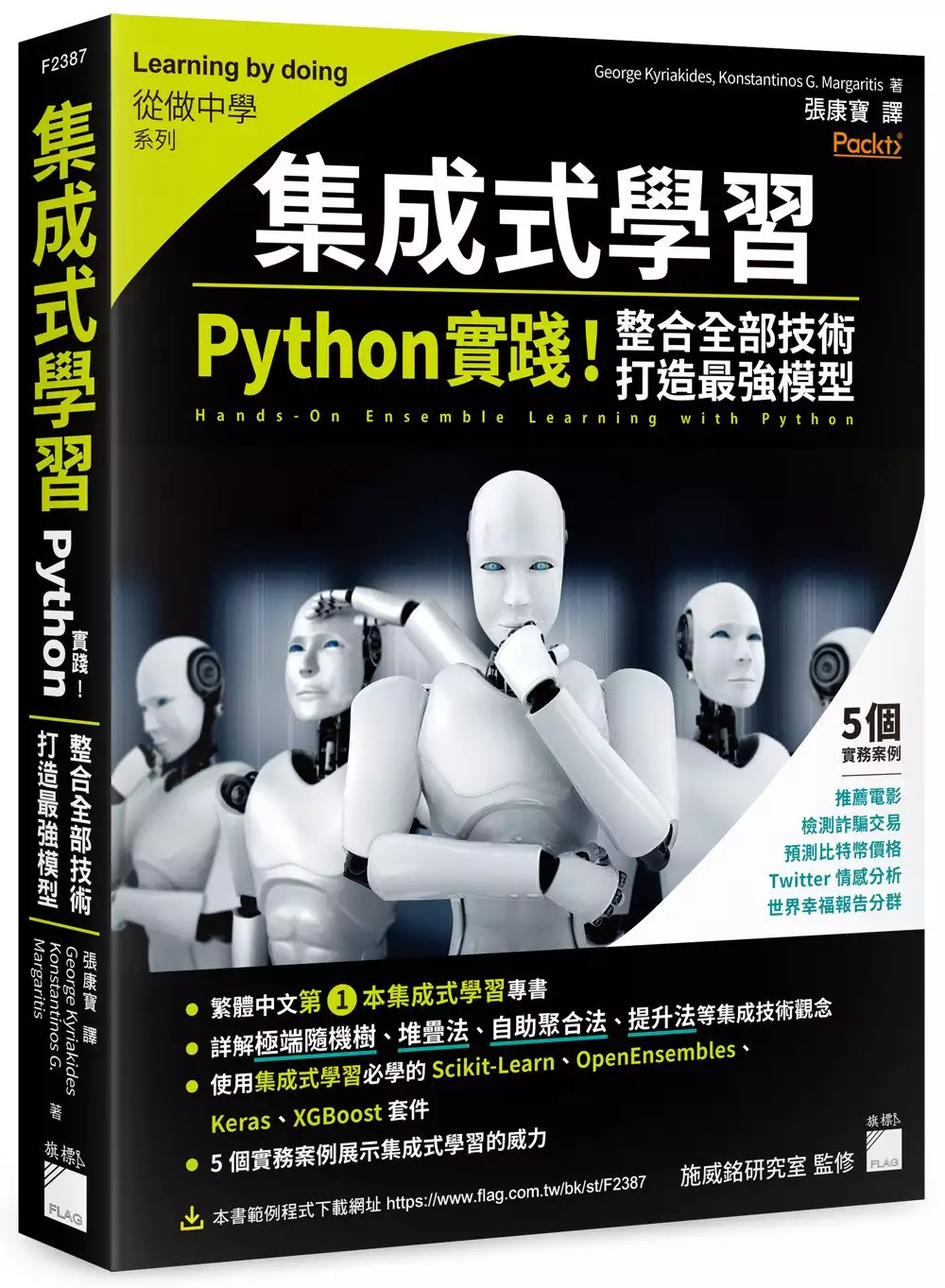

集成式學習:Python 實踐!整合全部技術,打造最強模型

為了解決DeepMind 的問題,作者GeorgeKyriakides,KonstantinosG.Margaritis 這樣論述:

別再傻傻只選一個模型 訓練很多模型,卻不知道應該選哪一個?沒有一個模型達標?每個模型都有其優缺點,無法取捨? 小朋友才做選擇,大人全都要!你該試試集成式學習! 集成式學習是使用 2 種或更多的機器學習演算法,來組合出預測能力更好的模型。DeepMind 已經使用集成式學習來組合多個神經網路,控制 Google 資料中心的運作效能;集成式學習技術也在 Kaggle 平台上,席捲了各個競賽的第一名寶座。因此,集成式學習是建立出更具威力的模型,不可或缺的技術之一。 本書會介紹實務上常見的集成式學習演算法,如硬投票、軟投票、堆疊法、自助聚合法、適應提升法、梯度提升法、隨機森

林、極端隨機樹等,並且使用熱門的 scikit-learn、Keras、OpenEnsembles、XGBoost 等 Python 函式庫來實作各種不同的集成式學習技術,建構出一個強大的模型。熟稔本書的內容後,不但可以精通集成式學習,在實際情境中面對問題時,亦能具備充分的專業知識判斷適用的集成式學習方法,並成功實作它們。 書中採用「做中學」的方式,讓你不僅可以快速掌握理論基礎,也能了解各種集成式學習技術的實作,再加上運用真實世界中的資料集,你將能夠建立出更佳的機器學習模型,以解決各種問題,包含迴歸、分類、分群。 現在翻開本書,讓我們一起進入集成式學習的世界,整合你所會的全部技術,

打造最強大的模型。 本書特色 ● 繁體中文第 1 本集成式學習專書,告訴你不要再傻傻地只選一個模型 ● 完整介紹集成式學習中常見的演算法,包含極端隨機樹、堆疊法、自助聚合法、提升法等 ● 一書掌握實作集成式學習的必備套件,如 Scikit-Learn、OpenEnsembles、XGBoost 等 ● 用 Python 刻演算法給你看,接著告訴你怎麼用套件。讓你不只會做,還懂為什麼這麼做 ● 以 5 個實務案例來展示集成式學習的威力 ● 本書由施威銘研究室監修,內容易讀易懂,並加入大量「小編補充」補充必要知識 ● 本書 Python 範例程式免費下載

具注意力之變異狀態追蹤器應用於語言視覺導航

為了解決DeepMind 的問題,作者張哲瑋 這樣論述:

近年有許多新興研究提出了處理機器人導航問題的方法,而語言視覺導航任務是其中最為現實的室內導航挑戰任務之一。這些方法中的大多數使用監督式學習將觀察直接映射到動作,或是利用基於策略的強化學習方法對預訓練的策略進行微調,抑或是基於模仿學習來解決語言視覺導航任務。語言視覺導航任務是一種離散控制任務,並且在這個任務中,從模擬器提供的觀察並不是完整的系統狀態。但傳統的強化學習是假設對於系統的觀察為一個符合馬可夫假設的系統狀態,因此並不能直接地用於此第一人稱視角的導航任務。在本研究,嘗試利用強化學習解決此導航任務,並將其視為一為部分可觀察馬可夫決策過程。為了能夠使用強化學習來解決部分可觀察馬可夫決策過程的

問題,一些方法遵循部分可觀察馬可夫決策過程的理論,成功地解決了一些非完美訊息的任務。儘管如此,這些方法中的大多數都適用於一些非現實的部分可觀察環境。例如:基於第三人稱視角機器人控制問題卻沒有提供實際測量值,或是提供部分畫面的電腦遊戲任務而沒有在每個時間點提供完整畫面。因此,本研究提出一種基於現代強化學習的方法來解決這類第一人稱視角並且真實的語言視覺導航任務。此任務在研究中將會被視為一種部分可觀察的問題。本研究中有三重新意。首先,我們提出了一個適合強化學習訓練的環境,可以用於在語言視覺導航任務中訓練策略函數。其次,本論文提出了具注意力之變異狀態追蹤器 (AVAST) 來推測環境的信念狀態,而不是

直接使用循環神經網絡聚合先前的觀察後的隱藏輸出作為環境狀態。與使用可能導致災難性遺忘的普通循環神經網絡不同,研究中所提出的狀態跟踪器使用變異型循環神經網絡和注意機制來估計置信狀態的分佈得以增強泛化的能力。因此,通過使用這種具注意力之變異狀態追蹤器,部分可觀察問題將可以簡化為一般馬可夫決策過程問題。第三,受到傳統強化學習理論的啟發,我們開發了一個簡單但有效的技巧,稱為帶有專家演示課程的循環經驗回放(RECED)。基於動態規劃的概念,若以終止狀態做為起點開始學習估計狀態價值表可以加快值表的訓練過程。因此,專家演示課程的技巧可以通過不同難度的課程幫助機器從終端狀態開始學習直到初始狀態。最後,本研究分

別使用競爭型雙重狀態動作價值學習和離散型柔性演員評論家演算法來引入了基於價值和演員評論家的強化學習方法,以與不同方法進行比較來評估本研究所提出的方法。根據實驗結果,可以發現本文提出的方法對比一些現有的方法具有較好的泛化性。

想知道DeepMind更多一定要看下面主題

DeepMind的網路口碑排行榜

-

#1.How Google DeepMind Turns AI Research into Application

In 2016, DeepMind was able achieve a 40 percent reduction in the amount of energy used for cooling Google data centers by training an ensemble ... 於 itpeernetwork.intel.com -

#2.蛋白質結構預測50 年難題? DeepMind 新一代AI 迎刃而解!

DeepMind AI 軟體可望解決蛋白質折疊難題 ... 早在2018 年的CASP 蛋白質結構預測競賽,DeepMind 已使用AlphaFold 來預測蛋白質結構,結果優於所有其他 ... 於 geneonline.news -

#3.英國Royal Free國家健康服務基金信託與Google DeepMind間 ...

資料來源:. Information Commissioner's Office [ICO], Royal Free-Google DeepMind Trial Failed to Comply with Data Protection Law (July 3, 2017),https ... 於 stli.iii.org.tw -

#4.What does Google want with DeepMind? Here are three clues

All eyes turned to London this week, as Google announced its latest acquisition in the form of DeepMind, a company that specialises in ... 於 theconversation.com -

#5.DeepMind news, articles and features | New Scientist

DEEPMIND · DeepMind's AI uncovers structure of 98.5 per cent of human proteins · DeepMind AI taught digital people to play football from scratch · LATEST IN ... 於 www.newscientist.com -

#6.Google's DeepMind Artificial Intelligence Unit Is No Longer a ...

DeepMind, which is likely the largest AI research operation in the world, has a very unique revenue model: it makes 100% of its money selling ... 於 www.fool.com -

#7.Deepmind | Latest News, Photos & Videos | WIRED

Find the latest Deepmind news from WIRED. See related science and technology articles, photos, slideshows and videos. 於 www.wired.com -

#8.DeepMind - 知乎

DeepMind 一家英国的人工智能公司,由人工智能程序师兼神经科学家Demis Hassabis等人于2010年联合创立,最初名称是DeepMind科技(DeepMind Technologies Limited), ... 於 www.zhihu.com -

#9.DeepMind 巨虧180 億、加拿大獨角獸遭3 折賤賣 - 報橘

相比DeepMind 和Open AI 還能在大公司的扶持下專注於技術研究,曾被加拿大視為「明日之星」的人工智慧獨角獸Element AI 似乎就沒有那麼幸運了。 走到盡頭 ... 於 buzzorange.com -

#10.DeepMind 相關報導- Yahoo奇摩新聞

最新最豐富的DeepMind 相關新聞就在Yahoo奇摩新聞,讓你快速掌握世界大事、財經動態、體育賽事結果、影劇圈內幕、社會萬象、台灣在地訊息。 於 tw.news.yahoo.com -

#11.DeepMind moves to TensorFlow - Google AI Blog

At DeepMind, we conduct state-of-the-art research on a wide range of algorithms, from deep learning and reinforcement learning to systems ... 於 ai.googleblog.com -

#12.DeepMind - Home | Facebook

2021 DeepMind x UCL RL Lecture Series - Introduction to Reinforcement Learning [1/13]. Research Scientist Hado van Hasselt introduces the reinforcement learning ... 於 www.facebook.com -

#13.DeepMind scholarships | Faculty of Engineering - Imperial ...

DeepMind scholars in the Department of Computing, Imperial College London. 於 www.imperial.ac.uk -

#14.'It's a transformation': Researchers are taking DeepMind's ...

David Baker's lab replicated DeepMind's protein folding technology. They've now turned it on whole new set of targets (University of ... 於 endpts.com -

#15.AI人工智慧公司DeepMind虧損連年攀升!收益仰賴Google 母 ...

DeepMind 是谷歌於2014 年收購的AI 人工智慧公司,隸屬谷歌母公司Alphabet 旗下,在全球擁有約1千名傑出員工,皆是世界頂尖的AI 研究科學家。 於 finance.ettoday.net -

#16.DeepMind團隊AI新突破!解決了長期困擾生物學界的「蛋白質 ...

DeepMind 是一家英國的人工智慧公司,該公司建立於2010年,最初名稱是DeepMind科技(DeepMind Technologies Limited),它在2014年被Google公司收購。 有了 ... 於 www.thenewslens.com -

#17.如今又有新突破:解決了長期困擾生物學界的蛋白質折疊問題

Google的DeepMind團隊開發了一種人工智慧演算法似乎已經破解了一道難題,這問題在生物學界已經困擾了好幾十年,甚至幾乎不可能解決,不過如今卻被人工 ... 於 tomorrowsci.com -

#18.Artificial Intelligence Goes to the Arcade - The New Yorker

Engineers at Google DeepMind have built a computer program that can master vintage arcade games. How will it shape the future of artificial ... 於 www.newyorker.com -

#19.Behringer DeepMind 12 49-key 12-voice Analog Synthesizer

With the DeepMind 12, Behringer set out to create the ultimate analog polysynth, a 12-voice beast that can effortlessly deliver any classic synth sound ... 於 www.sweetwater.com -

#20.Royal Free - Google DeepMind trial failed to comply with data ...

establish a proper legal basis under the Data Protection Act for the Google DeepMind project and for any future trials;; set out how it will ... 於 ico.org.uk -

#21.DeepMind - 《星海爭霸II》人工智慧展示

DeepMind - 《星海爭霸II》人工智慧展示. 更新: 指揮官們可透過以下連結觀看完整影片,包含人工智慧AlphaStar 與Team Liquid 戰隊選手Grzegorz "MaNa" ... 於 news.blizzard.com -

#22.Google to Buy Artificial Intelligence Startup DeepMind for $400M

Based in London, DeepMind was founded by games prodigy and neuroscientist Demis Hassabis, along with Shane Legg and Mustafa Suleyman. 於 www.vox.com -

#23.Google Turns Down DeepMind's Autonomy Bid - Analytics ...

Founded in 2010, DeepMind was bought by Google in 2014. DeepMind has been behind some of the most path breaking innovations in recent years, ... 於 analyticsindiamag.com -

#24.捉迷藏都難不倒它!Deepmind 推出最新泛用型遊戲AI「XLand」

從AlphaGo 之後,Google 母公司Alphabet 旗下的英國AI 企業Deepmind 一直在透過強化學習(Reinforcement learning,RL)技術挑戰各種遊戲,有星海爭霸2 的AlphaStar、 ... 於 www.inside.com.tw -

#25.深智數位股份有限公司

合作廠商. © 2021 深智數位股份有限公司- All Rights Reserved. | 聯絡方式: [email protected]. Close Bitnami banner. 於 deepmind.com.tw -

#26.DeepMind共同創辦人哈薩比斯破半世紀難題解鎖病毒蛋白質結構

倫敦人工智慧公司DeepMind最近利用人工智慧(AI)拆解與新冠病毒有關的蛋白質結構而聲名大噪。DeepMind共同創辦人兼執行長哈薩比斯(Demis Hassabis) ... 於 www.chinatimes.com -

#27.DeepMind_百度百科

DeepMind ,位于英国伦敦,是由人工智能程序师兼神经科学家戴密斯·哈萨比斯(Demis Hassabis)等人联合创立,是前沿的人工智能企业,其将机器学习和系统神经科学的最 ... 於 baike.baidu.com -

#28.DeepMind Wants to Reimagine One of the Most Important A...

In one of the most important papers this year, DeepMind proposed a multi-agent structure to redefine PCA. 於 www.kdnuggets.com -

#29.DeepMind - 9to5Google

DeepMind is Alphabet's AI research lab, and today, it unveiled AndroidEnv as a platform that allows reinforcement learning agents to “interact with a wide ... 於 9to5google.com -

#30.DeepMind巨亏42亿,AI公司为何难有“好下场”?

而比DeepMind巨额亏损更惨的是Element AI,这个背靠着全球最大深度学习社区的加拿大明星独角兽,在入不敷出的艰难处境下近期被低价甩卖。而同样的商业化 ... 於 finance.sina.com.cn -

#31.DeepMind co-founder: Gaming inspired AI breakthrough - BBC

Gaming inspired Demis Hassabis, the co-founder of DeepMind, to use artificial intelligence for a recent scientific breakthrough. 於 www.bbc.com -

#32.透過遊戲Metaverse,Deepmind讓AI學會玩各種沒玩過的遊戲

Deepmind 最新的AI智慧體可以在沒有玩過一款遊戲的前提下,能夠對全新的條件做出反應,並且玩完一整套遊戲。 於 www.techbang.com -

#33.Google's Deepmind Released AI Predictions to Curb COVID ...

Deepmind's AI system is pre-trained for several medical applications, like detecting neck cancer or developing models to identify eye disease in ... 於 interestingengineering.com -

#34.Product | DEEPMIND 12 - Behringer

DEEPMIND 12's pure analog signal path with legendary IR3109-style VCFs, stereo VCAs, and 12-voice polyphony lets you recreate all that magic or design the ... 於 www.behringer.com -

#35.Google's AI unit DeepMind makes first-ever profit - Financial ...

Google's UK artificial intelligence unit DeepMind made its first-ever profit last year, after losing half a billion pounds in 2019, ... 於 www.ft.com -

#36.What is DeepMind? - Definition from WhatIs.com

DeepMind is a division of Alphabet, Inc. responsible for developing general-purpose artificial intelligence (AGI) technology. That technology is also known ... 於 whatis.techtarget.com -

#37.AlphaFold Protein Structure Database

DeepMind and EMBL's European Bioinformatics Institute (EMBL-EBI) have partnered to create AlphaFold DB to make these predictions freely available to the ... 於 alphafold.ebi.ac.uk -

#38.Google地圖攜DeepMind 升級車程預測 - 工商時報

Google與母公司Alphabet旗下DeepMind AI研究實驗室合作,進一步降低預測 ... 的DeepMind實驗室合作,讓Google地圖能夠在真的塞車發生之前,就預測車程 ... 於 ctee.com.tw -

#39.DeepMind's AI predicts almost exactly when and where it's going

First protein folding, now weather forecasting: London-based AI firm DeepMind is continuing its run applying deep learning to hard science ... 於 www.technologyreview.com -

#40.Google DeepMind and healthcare in an age of algorithms

In 2016, DeepMind announced its first major health project: a collaboration with the Royal Free London NHS Foundation Trust, to assist in the management of ... 於 pubmed.ncbi.nlm.nih.gov -

#41.Alphabet挾DeepMind技術成立AI藥物探索新創公司Isomorphic ...

其旨在為生物製藥研究提供一種「人工智慧優先的方法」,目標是成為製藥公司的商業夥伴。 DeepMind執行長Demis Hassabis將同時兼任Isomorphic Labs初期的 ... 於 store.gbimonthly.com -

#42.DeepMind AI Firm Owes £1.04bn To Owner Alphabet

DeepMind, an artificial intelligence company based in London that Google bought for £400 million ($486 million) in 2014, is deeply in debt ... 於 www.pymnts.com -

#43.DeepMind打造會自主學習新規則的人工智慧MuZero - 聯合新聞網

Alphabet旗下人工智慧技術公司DeepMind,宣布推出名為MuZero的人工智慧系統,標榜在完全不了解規則情況下,即可快速熟悉圍棋、西洋棋、將棋, ... 於 udn.com -

#44.谷歌旗下DeepMind揭露人工智慧結合醫療企圖 - 科技產業資訊室

DeepMind 之人工智慧系統當然不是只能夠應用在下棋領域,為了進一步貢獻人類,將通過DeepMind Health與倫敦帝國理工學院以及倫敦皇家自由醫院展開合作。 於 iknow.stpi.narl.org.tw -

#45.DeepMind - Twitter

Last month, DeepMind released a specialized version of the original AlphaFold software for predicting protein-protein complexes. The new approach could help ... 於 twitter.com -

#46.Google DeepMind: A cheat sheet - TechRepublic

DeepMind is a subsidiary of Google that focuses on artificial intelligence. More specifically, it uses a branch of AI called machine learning, ... 於 www.techrepublic.com -

#47.DeepMind spins out new Alphabet company focused on drug ...

DeepMind, the London-based artificial intelligence research company that is owned by Google-parent Alphabet, is spinning off a new, ... 於 fortune.com -

#48.DeepMind發表AI天氣預測新模型- DIGITIMES 智慧應用

繼圍棋和電競遊戲後,DeepMind這回將觸角伸進天氣預報,與英國氣象局(Met Office)合作發表一篇關於天氣預測的論文,指出人工智慧(AI)可望協助人們在 ... 於 www.digitimes.com.tw -

#49.AI勝人腦谷歌DeepMind有助早期檢測乳癌 - Rti 中央廣播電臺

研究顯示,DeepMind AI系統在識別出癌症患者的比例,和放射線專家相似,同時還在美國組和英國組中,分別降低了5.7%和1.2%的不實陽性結果數量。 此外,AI ... 於 www.rti.org.tw -

#50.「跪舔」五年後谷歌終於有望將DeepMind融入 - 鉅亨

橫掃圍棋界的英國人工智慧公司DeepMind 有了新家:谷歌健康。隨著此前約定的五年收購期限臨近,谷歌也正重新審視DeepMind 的價值。 於 news.cnyes.com -

#51.How DeepMind Is Reinventing the Robot - IEEE Spectrum

But that's not stopping DeepMind from gathering all it can, with robots constantly whirring in its labs. And across the field, robotics researchers are trying ... 於 spectrum.ieee.org -

#52.DeepMind 每年虧損數億美元,Google 還要為人工智慧買單嗎?

為確保生存,防止Alphabet 突然終止輸血, DeepMind 不得不將自己重新定位為一個半商業化的機構。 △DeepMind 創辦人哈薩比斯. DeepMind 的收入困境. 在 ... 於 www.stockfeel.com.tw -

#53.DeepMind's AI for protein structure is coming to the masses

DeepMind sent shock waves through the scientific world last year, when it showed that its software could accurately predict the structure of ... 於 www.nature.com -

#54.打敗棋王後虧損破千億!AlphaGo開發商Deepmind今年終於賺錢

Deepmind 因開發AlphaGo此一圍棋電腦程式,利用AI打敗世界排名的圍棋選手,一舉成名且被Google收購,之後卻持續虧損,終在今年由虧轉盈。 於 www.bnext.com.tw -

#55.DeepMind - MultiAdaptor

A new visual identity for a world-leader in AI. Established in 2010, DeepMind is one of the world's most influential artificial intelligence companies. 於 multiadaptor.com -

#56.DeepMind - 維基百科,自由的百科全書

Alpha[編輯] ... DeepMind於2014年開始開發人工智慧圍棋軟體AlphaGo。 2015年10月,分散式版AlphaGo分先以5:0擊敗了歐洲圍棋冠軍華裔法籍職業棋士樊麾二段 。這是電腦圍棋 ... 於 zh.wikipedia.org -

#57.Deepmind | iThome

Deepmind. | Alphabet | 新創 | Isomorphic Laboratories | 人工智慧 | AI | 藥物 ... 於 www.ithome.com.tw -

#58.Alphabet 成立新藥物研發公司以DeepMind 人工智慧 ... - Cool3c

DeepMind 已經提出AlphaFold2人工智慧系統,透過類神經網路在幾分鐘內完成蛋白質折疊結構分析,並且標榜可達原子等級的精準度。 於 www.cool3c.com -

#59.DeepMind is developing one algorithm to rule them all

DeepMind is trying to combine deep learning and algorithms, creating the one algorithm to rule them all: a deep learning model that can learn ... 於 venturebeat.com -

#60.DeepMind - Crunchbase Company Profile & Funding

DeepMind is a research company that specializes in artificial intelligence for positive impact. 於 www.crunchbase.com -

#61.DeepMind | LinkedIn

DeepMind | 265249 位LinkedIn 關注者。Our team research and build safe AI systems. We're committed to solving intelligence, to advance science and humanity. 於 tw.linkedin.com -

#62.DeepMind reportedly lost a yearslong bid to win more ...

Tensions between Google and its AI brain trust DeepMind have always been fascinating. To put the relationship in crude terms: DeepMind, ... 於 www.theverge.com -

#63.DeepMind AI系統檢測乳癌準確度超過專家,可大幅降低X光 ...

DeepMind 在《自然》科學期刊發表了一個經9萬筆資料訓練的人工智慧模型,能夠比人類放射線專家還要. 於 ibmi.taiwan-healthcare.org -

#64.AI個資爭議在英國與歐盟之經驗 以Google DeepMind一案為例

何之行,廖貞,Google DeepMind,人工智慧(AI),英國資訊委員辦公室(ICO),歐盟一般資料保護規則(GDPR),科學例外條款(scientific exemptions),本文分析,月旦知識庫, ... 於 lawdata.com.tw -

#65.Why Google Just Tightened Its Grip On DeepMind - Forbes

Google will now directly manage DeepMind Health, a division of DeepMind that the company describes as its "first effort" to achieve its social ... 於 www.forbes.com -

#66.Blog - Isomorphic Labs

Last year DeepMind's breakthrough AI system AlphaFold2 was recognised as a solution to the 50-year-old grand challenge of protein folding, capable of predicting ... 於 www.isomorphiclabs.com -

#67.DeepMind Fellowships | Computer Science - UCSD CSE

These fellowships were made possible by a recent generous gift from DeepMind, a London-based leader in artificial intelligence (AI) research and how it's ... 於 cse.ucsd.edu -

#68.Google's $500+ Million Acquisition of DeepMind Is Looking ...

But now Google is using a DeepMind AI system to control the huge air-conditioning units in its power-hungry data centers, where servers consume ... 於 www.businessinsider.com -

#69.Alphabet launches AI drug discovery venture built on ...

Last year, researchers at DeepMind showed they were able to help solve a riddle that has stumped scientists for decades: How do proteins ... 於 www.fiercebiotech.com -

#70.Google Unit DeepMind Tried—and Failed—to Win AI ...

Founded in 2010 and bought by Google in 2014, DeepMind specializes in building advanced AI systems to mimic the way human brains work, an ... 於 www.wsj.com -

#71.DeepMind: Homepage

Artificial intelligence could be one of humanity's most useful inventions. We research and build safe artificial intelligence systems. 於 deepmind.com -

#72.DeepMind Lab – opensource.google

DeepMind Lab is a first-person 3D game platform designed for research and development of general artificial intelligence and machine learning systems. 於 opensource.google -

#73.DeepMind Safety Research – Medium

Read writing from DeepMind Safety Research on Medium. We research and build safe AI systems that learn how to solve problems and advance scientific ... 於 deepmindsafetyresearch.medium.com -

#74.Deepmind - Towards Data Science

Through AlphaFold, Google's DeepMind is pushing boundaries in the field of medical science by addressing the age-old Protein Folding Problem. 於 towardsdatascience.com -

#75.Yes, DeepMind crunches the numbers – but is it really a magic ...

What DeepMind has brilliantly demonstrated is that the combination of smart algorithms and brute-force computing is good at some rather ... 於 www.theguardian.com -

#76.DeepMind - GitHub

DeepMind's software stack for physics-based simulation and Reinforcement Learning environments, using MuJoCo. Python 2.5k 464. 於 github.com -

#77.DeepMind 完整報導- Engadget 中文版

DeepMind articles, stories, news and information. 於 chinese.engadget.com -

#78.DeepMind 研究結合深度學習與傳統算法 - UNWIRE.PRO

DeepMind 研究負責人Charles Blundell 和高級研究科學家Petar Veličković 最近發表的一份論文,就提到了神經算法推理(NAR) 技術,這個技術希望可以 ... 於 unwire.pro -

#79.Alphabet成立新藥物研發公司,藉由DeepMind人工智慧技術獲利

不過,Isomorphic Laboratories本身並非投入藥物生產,而是藉由DeepMind人工智慧技術提供藥物相關分析模型,讓藥商能以此加快新藥研發速度。 而DeepMind ... 於 mashdigi.com -

#80.DeepMind says it can predict the shape of every protein in the ...

AI firm DeepMind says it can predict the shape of every protein in the human body and in 20 species of research animals. 於 www.livescience.com -

#81.Behringer Deepmind 12 合成器鍵盤| DigiLog 聲響實驗室

True Analog 12-Voice Polyphonic Synthesizer with 4 FX Engines, 2 OSCs and LFOs per Voice, 3 ADSR Generators, 8-Channel Modulation Matrix, 32-Step Control ... 於 digilog.tw -

#82.[1612.03801] DeepMind Lab - arXiv

DeepMind Lab is a first-person 3D game platform designed for research and development of general artificial intelligence and machine learning ... 於 arxiv.org -

#83.Google Acquires Artificial Intelligence Startup DeepMind For ...

Google will pay $400 million to buy London-based artificial intelligence company DeepMind. The deal, but not the exact price, was confirmed ... 於 techcrunch.com -

#84.DeepMind - latest news, breaking stories and comment - The ...

DeepMind unveils AI that can master chess without even knowing rules · AI researchers at DeepMind discovered new details about how the human brain works. 於 www.independent.co.uk -

#85.Alphabet has a new drug discovery company ... - Stat News

Over the last year, the tech behemoth and Google parent company has made a large and unlikely splash in the world of biology. DeepMind, its AI ... 於 www.statnews.com -

#86.DeepMind becomes profitable—and more enmeshed in ...

DeepMind's main area of focus is deep reinforcement learning, a branch of machine learning that is very useful in scientific research. DeepMind ... 於 bdtechtalks.com -

#87.黃士傑-Google DeepMind工程師 - 國立臺灣師範大學資訊工程 ...

現為英國DeepMind工程師,是人工智慧AlphaGo的重要推手。 2010奧林匹亞電腦遊戲程式競賽圍棋冠軍。 於 www.csie.ntnu.edu.tw -

#88.Blizzard、DeepMind聯合發表,1/25讓AI玩《星海爭霸II》給你看

拉好板凳!Blizzard、DeepMind 今(23)日攜手宣布,將於台灣時間1 月25 日凌晨2 時展示最新《星海爭霸II》人工智慧(AI)研究成果, ... 於 www.4gamers.com.tw -

#89.Google is teaming up with a London hospital to inject AI into ...

Google DeepMind just announced a partnership with University College London Hospital which will explore using artificial intelligence to ... 於 qz.com -

#90.Alphabet's DeepMind A.I. lab turns a profit for the first time ever

DeepMind doesn't sell products directly to consumers and it hasn't announced any deals with private companies outside of the Alphabet umbrella. 於 www.cnbc.com -

#91.多年密謀「獨立」,Google 為何拴不住DeepMind 的心?

多名DeepMind前任和現任員工都表示:DeepMind一直覺得業務出售給不信任的人,擔心Google有朝一日濫用技術。多年高層努力使這家人工智慧公司與擁有者 ... 於 technews.tw -

#92.DeepMind: The Podcast - Apple Podcasts

In this special extended episode, Hannah Fry meets Demis Hassabis, the CEO and co-founder of DeepMind. She digs into his former life as a chess player, games ... 於 podcasts.apple.com -

#93.Alphabet Chases Wonder Drugs With DeepMind AI Spinoff ...

After DeepMind's breakthrough in protein folding last year, Alphabet will double down on artificial intelligence in biology and health with ... 於 singularityhub.com -

#94.DeepMind、人工智慧、智慧醫療、英國- 產業技術評析

DeepMind 由認知神經學家Demis Hassabis等人在2010年創立,總部位於英國倫敦,初期的人工智慧研究聚焦在遊戲領域的研究。2014年,Google看好DeepMind在 ... 於 www.moea.gov.tw